Backup et restauration des datacenters

Module ARCHITECTURES du système d’information et technologies du datacenterLe backup et la restauration des gros volumes de données, reste une fonction régalienne hyper-sensible des datacenters

Même si c'est moins "glamour" que l'IA, la fonction "backup" et restauration est toujours essentielle, qu'il faut traiter avec d'autant plus de rigueur que l'environnement est très fragile, à la merci d'un dysfonctionnement ou d'une attaque.

Il ne s'agit pas ici de la sauvegarde des PC, mais des technologies centrales, adossées à des systèmes PCA/PRA de continuité et reprise d'activité, qui garantissent la permanence des services.

Les solutions se sont fortement diversifiées, avec quelques stars telles Veeam, Acronis, IBM, HPE..., le Cloud jouant désormais un rôle central ('Backup as a Service"). Nous vous invitons dans ce webinaire à regarder ce qui se fait de mieux dans la planète "datacenter" : les solutions classiques, la déduplication, les librairies virtuelles de bandes, les technologies synchrones et asynchrones en local, dans un datacenter éloigné ou spécialisé ou dans le Cloud. Le tout avec en toile de fond les obligations de chiffrement et de garantie d'intégrité et de contraintes règlementaires, sans oublier le droit d'ingérance que se sont octroyés les américains avec leur "Patriot Act".

Programmer les "mains dans les poches"

Le "vibe coding" est une autre forme d’assistance au codage. Cette fois, on n’a pratiquement plus rien à faire. Pas sûr que cela fasse plaisir à tout le monde.

L’état de l’art de la vision par ordinateur

La vision artificielle ou reconnaissance d’images par ordinateur est l’un des domaines qui a le plus progressé ces dernières années. La "faute" encore à l’Intelligence Artificielle, dont la quasi-totalité des applications sont demandeuses. Rien d’étonnant à ce que cela bouge autant.

Pleins feux sur ces inventeurs qui ont façonné le TI moderne.

Les grandes innovations technologiques qui ont marqué les 50 dernières années du TI sont rarement le résultat d’une stratégie pensée par les grands acteurs, hormis IBM qui a toujours fait confiance pour cela à ses laboratoires (sauf pour le PC), voire Xerox. En général, elles sont le résultat de fulgurances émises par des individus, tout seuls dans leur coin, qui se sont dit "pourquoi pas"…

La robotique, où en est-on ?

La robotique ne peut pas être dissociée des algorithmes, car ce sont eux qui les animent de l’ "intérieur". Mais on continue de la distinguer, sans doute parce qu’elle est entrée dans les mœurs beaucoup plus tôt que l’IA.

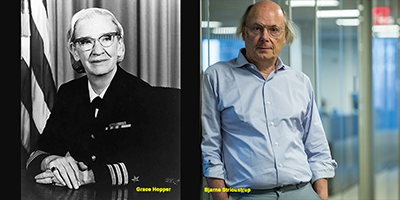

Grace Hopper et Bjarne Stroustrup, une même flamme à 30 ans d’intervalle

Grace Hopper et Bjarne Stroustrup sont 2 personnages incontournables, sans qui le développement n’aurait jamais été ce qu’il est devenu.

Le tsunami des architectures applicatives

Il y a encore quelques années, il n’existait qu’une seule architecture applicative : monolithique. Tout était concentré en un seul lieu logique : code et données Dans les années 90, la puissance des machines aidant, certains ont imaginé le mode client-serveur en confiant une partie du traitement au local. Ce fut un désastre.

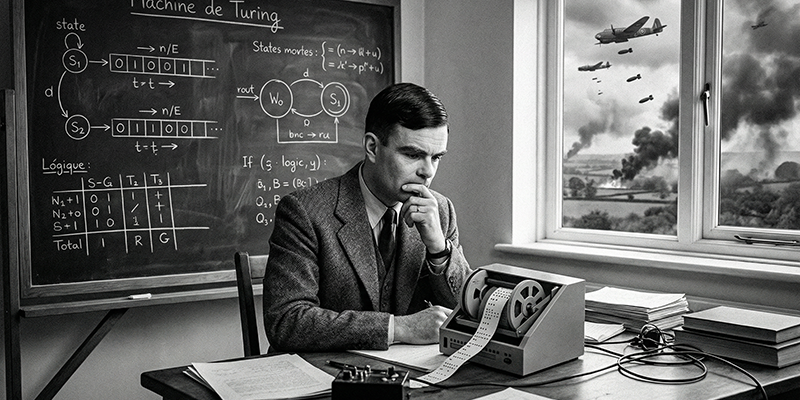

La machine de Turing, une référence théorique

La machine de Turing est un concept d’ordinateur, imaginé en 1936 par Alan Turing, l’extraordinaire mathématicien britannique, pour donner corps au concept d’algorithme et de procédure mécanique.

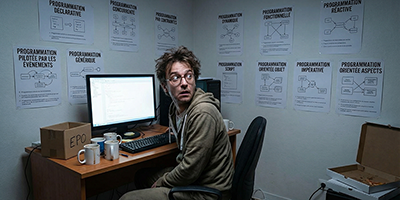

Le labyrinthe des modes de programmation

Les développeurs font face à une multiplicité de formes de programmation, liées aux architectures applicatives. Parmi lesquelles ils doivent faire un choix, éventuellement se former. Ce qui n’est pas facile. Du seul codage impératif d’autrefois, ils sont passés à un véritable labyrinthe où il est très facile de se perdre.

Les religions et l’Intelligence Artificielle

Nous sommes en train de vivre une transformation à nulle autre pareille, qui touche tous les domaines. Les religions n’y échappent pas. On peut en parler.

Les bases et arbres de connaissances

L’efficacité d’une entreprise et celle d’un algorithme d’IA dépend pour l’essentiel des données sur lesquelles ils peuvent s’appuyer. Il suffit donc de transférer ces données dans une base de données dédiée. C’est vrai, sauf que c’est tout sauf simple.

Ouvrons les portes de la recherche TI

L’Intelligence Artificielle n’est pas une fin en soi, même si elle occupe une grande partie de nos préoccupations. La recherche dans le TI a depuis longtemps anticipé sur le futur et dégagé des voies qui continueront de nous surprendre.

Les datacenters dans le désert ou la banquise

Depuis toujours, d’immenses territoires sont réputés incompatibles avec les pratiques de notre société. Cela va changer et les datacenters seront les premiers à s’installer dans les déserts et zones froides de la planète. C’est déjà le cas.

Pour nos abonnés

- Suivez LeMarson en direct

- Accédez à des centaines de dossiers et d'articles

- Visionnez des dizaines d'heures de formations vidéos

- Téléchargez le Livre des tendances de l'année